不同于两年前的百模大战时期谁都可以喊一句“冲击AGI”,如今创业公司再坚称自己以此为目标已经不是一种主流行为——但这仍是阶跃星辰要在2025年延续的叙事。

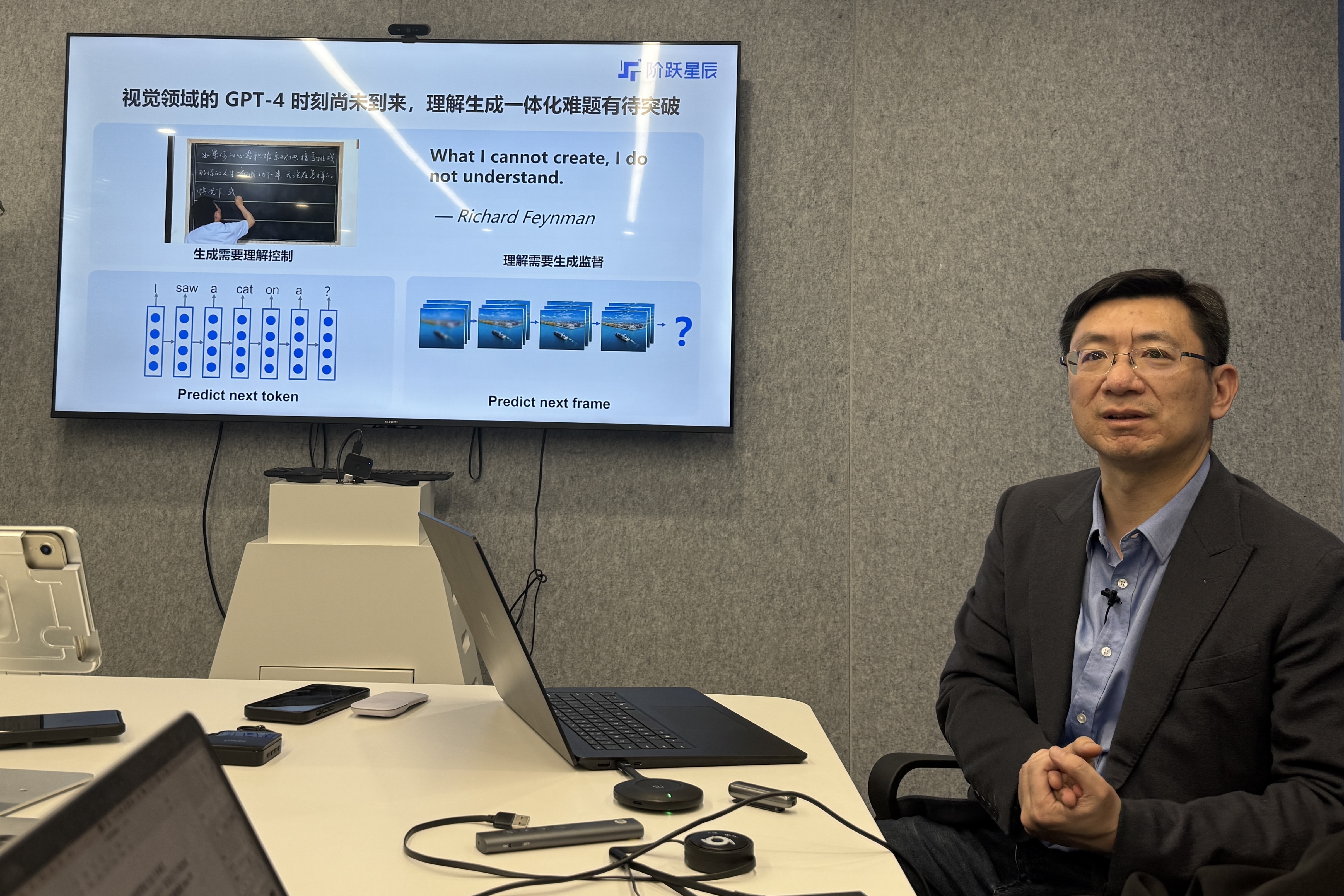

5月8日,阶跃星辰创始人兼CEO姜大昕进行了一场技术沟通会,强调公司的技术追求并对未来技术趋势作出判断。对于公司从Day 1起便明确的“单模态—多模态—多模理解和生成的统一—世界模型—AGI(通用人工智能)”路线图,他也予以明确了当下时刻的定位。

几乎以低调贯穿整个成立初期的阶跃星辰,从去年下半年起主动对外释放更多声量,开始打一场水面之上的仗。

这些声量大都围绕模型进展。成立两年,公司累计发布22款基座模型,覆盖文字、语音、图像、视频、音乐、推理等系列。其中有16款是多模态模型,又分属图像理解、视频理解、图像生成、视频生成、图像编辑、音乐生成、多模态推理等方向。

区别于行业更常见的图像模型、音频模型、视频模型等不加区分的定义和命名方式,阶跃星辰格外强调多模态模型“理解”与“生成”的单一属性。这与这家公司选择的AGI路线以及即将要突破的关键节点息息相关。

“从模仿学习走向强化学习,以及从多模态融合走向多模态理解与生成一体化,是当下大模型发展主要呈现的两个趋势。”姜大昕开场点明了这一主题。

第一条趋势行业并不陌生,这是OpenAI去年9月通过o1-preview掀起的模型训练范式革命,并且主导了接下来数月几乎所有大模型公司的迭代方向。随着推理模型与后训练成为业界共识,文本模型的技术路线相对收敛,这里的格局变换已不如从前那样日新月异。

另一条趋势属于多模态模型,这是一个最优技术路径尚不明朗的领域,阶跃星辰在此押下重注。

“有一句话我在很多场合不停重复——我们认为多模态是实现AGI的必经之路。”姜大昕指出,无论是从人类智能的多元化角度(符号智能、视觉智能、空间智能等),还是从垂直领域AI应用需求来说,大模型的多模态能力都必不可少。

这家公司进一步判断,在多模态模型领域,理解与生成统一是其核心问题。

文本大模型的理解与生成已经由GPT类模型实现统一,但在视觉领域,内容的理解与生成仍普遍采用不同模型,例如用GPT-4o来理解图片,但用Flux、Stable Diffusion等来生成图片。

为什么一定要做多模理解与生成的统一?姜大昕解释称,一方面生成的内容需要理解来控制,确保内容具备意义和价值;另一方面,内容的理解需要生成来监督,也即“只有能够生成的时候才意味着真正的理解了”。

从统计学角度看来,相比文本模态的低维度离散分布,视觉模态的高维度连续分布造就了模型学习更高的复杂性。

这使得文本模型的NTP(Next-Token-Prediction)还无法顺畅平移为视觉模型的NFP(Next-Frame-Prediction),也意味着属于视觉模型的可规模化理解生成一体化架构尚未出现——这正是Transfomer架构之于GPT等文本模型的重大意义。

姜大昕坦言,视觉领域的确处在一个等待“Transformer架构”出现的阶段,而行业也在探索多个不同方向,公司当前的目标是要自己把“Transformer”做出来。

在他看来,拥有了这一架构的视觉模型,可以效仿文本模型的路径,顺利迈入海量图片和视频预训练及指令跟随的GPT-3阶段,并可能加速进入融合了强化学习的视觉时空推理阶段,直至诞生世界模型。

这也是为什么他会说,“一旦视觉模型理解与生成一体化的问题被解决,之后的路线会非常顺畅”。

作为该技术目标的最新进展,阶跃星辰近期发布了图像编辑模型Step1X-Edit,多模态推理模型Step-R1-V-Mini,以及图生视频模型Step-Video-TI2V。姜大昕指出,Step1X-Edit实现了初步的理解与生成统一,但还可以在架构和数据上做进一步优化和打磨。

技术路线之外,阶跃星辰梳理出了一条更明确的商业化路径。

除了此前已有的ToC(用户)产品尝试和ToB(企业)合作模式,阶跃星辰将在应用层重点发力的方向是AI Agent。不过相较于自己做一款Manus类的产品,公司选择聚焦智能终端Agent领域,也就是与手机、汽车、机器人等终端厂商合作,以端云结合平台的角色构建智能终端的Agent生态。

作为一家已融资数亿美元的B轮创业公司,这场沟通会没有大谈用户规模、商业模式、盈利能力,更多话题还是围绕如果要实现AGI,公司要如何翻越既定路线上的某一座山头。这种氛围在当前行业热议AI应用公司如何火热、挣钱的喧嚣衬托下,颇有一种反差。

此外,姜大昕还接受了界面新闻等媒体采访,更细致回答了有关多模理解与生成统一技术路径的相关问题,以及对模型训练与商业化的基本判断。

以下为姜大昕采访实录,略作编辑:

媒体:跃问最近改名阶跃AI了,原因是什么?公司过去一年发布过一些C端产品,目前对这个方向有什么经验总结?

姜大昕:去年大模型还没有出现这么强大的多模态和推理模型,我们看到的产品就几类,Chatbot,AI陪伴,还有Runway、Pika这样一些AIGC应用。那时候大家其实没有特别明确的方向,只是因为有这样的模型能力,所以产生了这样的应用。这是产品探索的早期阶段。

今年因为多模态能力和推理能力的进一步成熟产生了Agent,我们看到非常多像Deep Research或者Manus这样的新应用。

我们的变化是想聚焦到Agent领域。而之所以改名阶跃AI,是因为它要从Chatbot类产品向加入更多Agent能力的产品做转变。

媒体:阶跃的策略是超级模型+超级应用,这也是包括字节在内很多大厂在做的事情,这种情况下,很多初创公司已经放弃通用大模型了,阶跃为什么还会坚持?

姜大昕:这里面分几个层次去讲,第一,现在这个行业趋势还处于一个技术非常陡峭的区间。

我会很感慨,AI行业里面的发展变化确实是太快了。如果大家回到去年想一想,就觉得GPT-4是多么牛的东西,今天它都要快下架了;去年Sora刚出来的时候给大家多大的震撼,今天回过头看,都觉得Sora有什么神奇的。而今年无论做出什么很牛的技术,可能明年回头看会觉得微不足道。

在技术发展如此快的行业背景下,阶跃肯定不愿意在这个过程中脱离主流,或者说放弃这样的前进趋势,还是会坚持做基础模型的研发。

第二,从应用的角度来看,我们一直觉得应用和模型是相辅相成,模型可以决定应用的上限,应用给模型提供具体的场景和数据也非常重要。所以我们的产品形态随着模型的演变动态发展,这样的逻辑关系会一直保持下去。

媒体:在Agent这件事情上,为什么会选择一个类似供应商的身份,而不是自己下场做一款直接ToC或者ToB的Agent产品?

姜大昕:这个东西很新,我们更好的选择就是找到头部企业合作。它们已经有了大量的用户和场景,我们才能尝试这个模型究竟怎么做。

如果我们上就来做ToC,第一件事情就得是user grow(用户增长)。所以我们先和这些企业一起合作,如果这件事情探索清楚了,至于说将来我们是不是自己做,我觉得都是有可能的。

这里还有一个很诱人的场景,就是现在所有的设备都是孤立的,对于一个用户来说,他当然希望AI Agent能够跨设备。那么这件事情应该谁来做,肯定有很多人在思考。

媒体:公司最近在算法层面更加重视理解生成一体化整合,这个想法是基于什么样的逻辑判断?

姜大昕:我们觉得以Sora为代表的这一代视频生成技术,它的上限就在那里了,很难去突破。下一代突破我们认为应该是基于理解生成一体化的。

媒体:多模态理解与生成一体化架构很重要,那影响它出现最关键的因素是算法,更高质量的数据,还是什么?

姜大昕:两个都很重要,首先就是架构的突破,因为确实不容易。

多模态的高维连续空间,我们很难用一个自回归架构去模拟,所以大家不得不采用Diffusion。直白的说,Diffusion就是一步弄不成,就多走几步,因为它太复杂了。

但自回归架构不让你走多步,那么这两个东西怎么能连在一起,需要一个架构性的东西,这是算法层面需要解决的问题。甚至有可能把自回归和Diffusion结合在一起这个方向也是错的,这里面有非常多的不确定性。

有了技术以后,第二步就是数据。所有的人工智能里面数据都非常重要,有了架构但没有合适的数据训练它,就如同一辆车没有石油,你还是不能跑。

媒体:你刚刚好像有提到,OpenAI最新的GPT-4o已经实现了理解与生成一体化?

姜大昕:我们只是猜测,因为它从不公布技术细节。它的做法应该是把理解和生成放在了一个模型里面,但这个东西是不是scalable(可规模化),我们不知道。

媒体:怎么判断它是不是scalable?

姜大昕:它肯定要做到predict next frame,或者说如果OpenAI有一天推出了一个不叫Sora的视频模型,很可能就是做通了。

事实上去年Sora出来的时候大家都很兴奋,但我们是非常失望的,因为我们觉得它的主线应该是做理解生成一体化。

回过去想也是有道理的。从多模融合一步走到理解生成一体化太难了,所以干脆两个独立往前走,互相促进,有点像左脚踩右脚。因为它在Sora里面也说了,它拿着GPT-4o给数据打标注。

有了生成以后是不是能够帮助理解,可能就是需要迭代几轮以后再到理解生成一体化,但总的方向肯定是能够predict next frame。这个问题不解决,后面有很多问题都到不了那个程度。

媒体:多模态理解与生成一体化这个技术方向目前还没有收敛,对标语言模型的话,它大概处在哪个发展阶段?

姜大昕:应该是在Transformer的阶段,Transformer是2017年出来的,GPT-1是2018年,这个架构应该早于“GPT”。

媒体:阶跃目前研发的模型很多,如果下一步理解生成一体化尤为重要的话,为什么我们不把所有的力量都集中去做它?

姜大昕:我们也想这样做,但不行,因为理解与生成一体化是非常要求综合素质的一个考验。首先你要理解,如果语言模型不强就谈不上理解。其次你要做推理,视觉推理是视觉理解的升级。再者还有生成端,这也必须得做。

所以不是我们不够focus(专注),要做这件事,就必须要做到所有条线能力都非常强,组合起来去探索它的路径。

媒体:解决理解与生成一体化这个问题之后,你认为视觉模型应该达到一个什么样的状态?

姜大昕:你给它一个电影的开头,它能够一直往下编,并且大家认为还挺有道理的,连续、符合逻辑、符合物理规律。如果它能持续这样做下去,这至少可以说明它的预训练做成了。